4网线绑电池为什么能提高网速|网线绑电池为什么能提高网速,网线绑电池提高网速可行吗

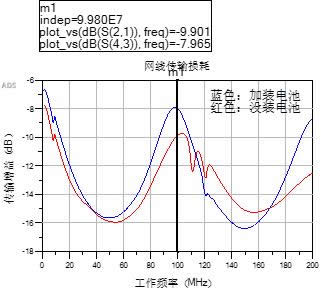

将测试平台连接到矢量网络分析仪上并导出S参数,然后导入到计算机端的ADS进行分析,得出下面的测试参数!

让我来解释一下上面两个曲线,X坐标是测试频率从0MHz-200MHz,Y轴是传输增益,正数代表放大,负数代表衰减,一般无源信号线都是成衰减特性,其单位是dB,-8dB意思是输出信号功率是输入的15%、-10dB意思是输出信号功率是输入的10%。(当然,考虑到巴伦的影响,这个结果并不意味着传输线衰减了90%的信号,这样做只是为了比较红蓝线)

测试图标中红色线是没有加装电池的测试线!蓝色线加装电池的测试线!由图中可以看出加装电池(碳棒)以后,在DC-100MHz范围内性能获得了提升!并且在100MHz的时钟频率获得了高达2dB增益,接收端信号能量直接相对提升了58.4%(PAfter/PBefore=10^(0.2)=1.584)

分析:根据数字通信原理中的香农定理,加装电池后信噪比S/N得到了提升!从而信道容量提升了,其结果就是数据传输过程中帧接收出错的概率减小了,因此系统要求数据重传的概率减小了!其宏观直接结果就是——网速真的相对地提升了!

卧槽牛逼啊,不分析我也不知道,加个破电池真的可以提升网速!只能说原po6666666!

真相只有一个,本人学生仔一枚,实验做得略显粗糙,欢迎电磁场射频微波技术/信号完整性相关领域砖家多做测试检验实验结果,经得起考验的结论才是真理!!!

关于原视频,最终结论就是:

接收信号的能量功率值相对提升了2dB,然而其他的并没有什么卵用!这种方法实践上证明有效,但是你看不到那微乎其微的效果!简单地说,加跟没加是一样的!doge脸,“mbps”是“毫比特每秒”也就是 10^-3bps。而Mbps 是“兆比特每秒”也就是10^6bps。两者意义大不相同,Mbps只跟隔壁老王有关系,跟小头爸爸mbps没关系。“利用电磁场改变信号频率”。在不存在多普勒效应或者爱因斯坦理论里的时空弯曲的情况下,电磁场是不能改变信号频率的!最后测网速的时候说“带宽是百兆所以速率也是百兆”。百兆带宽以太网网速最高100Mbps也就是12.5MBps(M/s)除去信令开销,最高传输速度为11M/s左右。路由器100Mbps。再怎么改网线都是不可能突破路由器限制改成1000Mbps网速的。

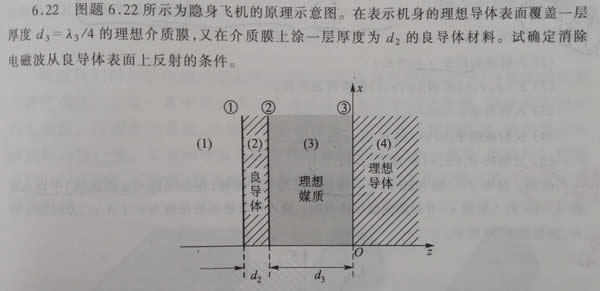

关于磁环、碳棒那一段,可能存在强行解释的嫌弃,实际上由于网线缠绕电池网线上相当于多串一个电感,这个电感在100MHz的工作频率下可能呈现出感性也可能呈现出容性,但是不管怎样,它使得传输线更加接近于最佳匹配状态,使得功率信号能够最大化传输。另外考虑到电池表面的铁介质,对于被理想导体包围的理想介质以及接近理想导体的碳棒,这个模型架构更加接近于隐形飞机的表面材料,理论上铁与电解质表面的波阻抗是无穷大,电磁场应该是无法接触到碳棒的,或者说其量很小。因此自己推翻自己,碳棒模型应该是不正确的。

最后从实验的角度看,更应该将导线信道看成一个系统,缠绕电池后系统冲击响应发生了变化,传输增益获得了提升,但是实际上2dB的性能并没有任何卵用,在最终的宏观现象看来,网速增益可能连1kbps的网速提升都不到。mbps存在争议,有些外文文献确实有这种说法,不予讨论~

总结:我们可以这么来看,每台电脑配置不一样,网卡不一样,网卡驱动不一样,运营商不一样,传输协议不一样,每经过一次适配转码,都会损失一定的传输效率,这个方法可以有效提升家用终端和区位总线之间的信号传递,但是不能提升总的网速,也就是说这个方法可以把一定的损失传输效率给弥补。

……